بهبود تخمینهای عدم اطمینان توو مدلهای یادگیری ماشین

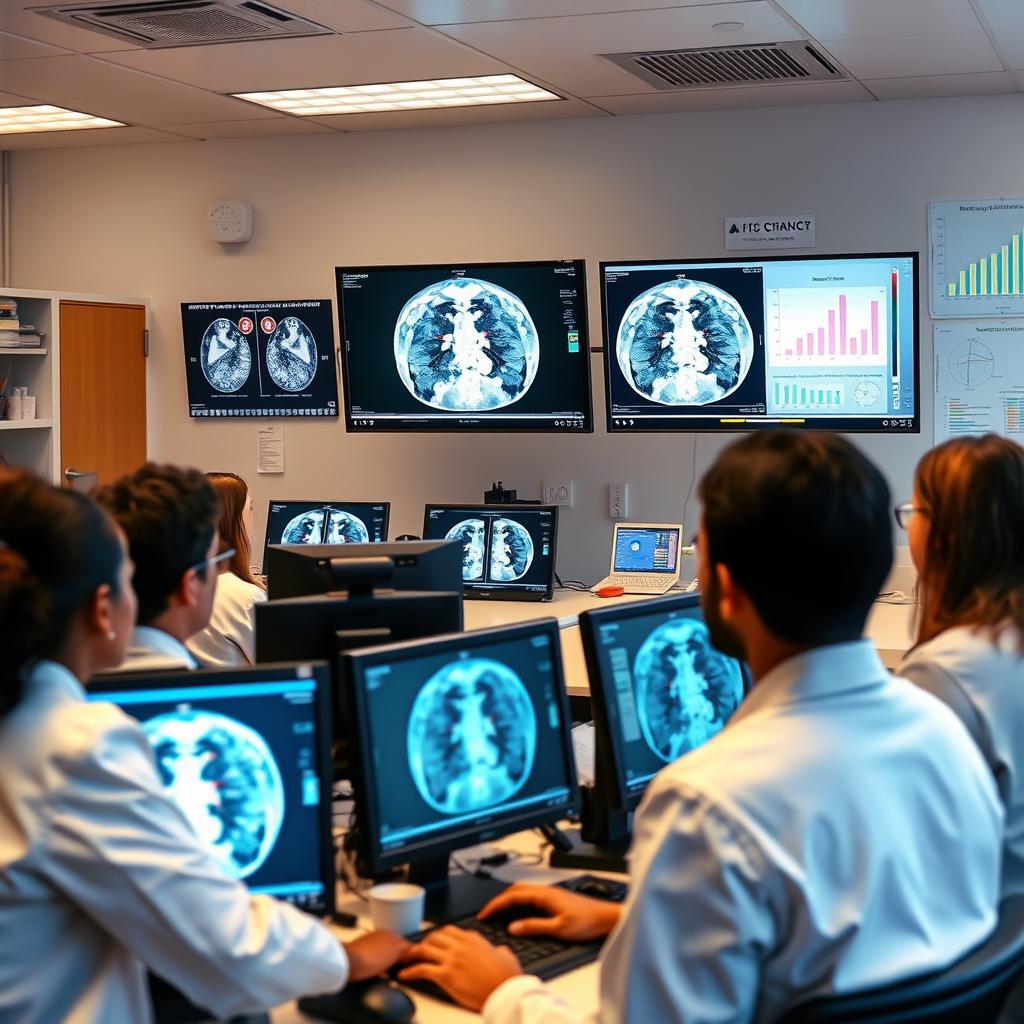

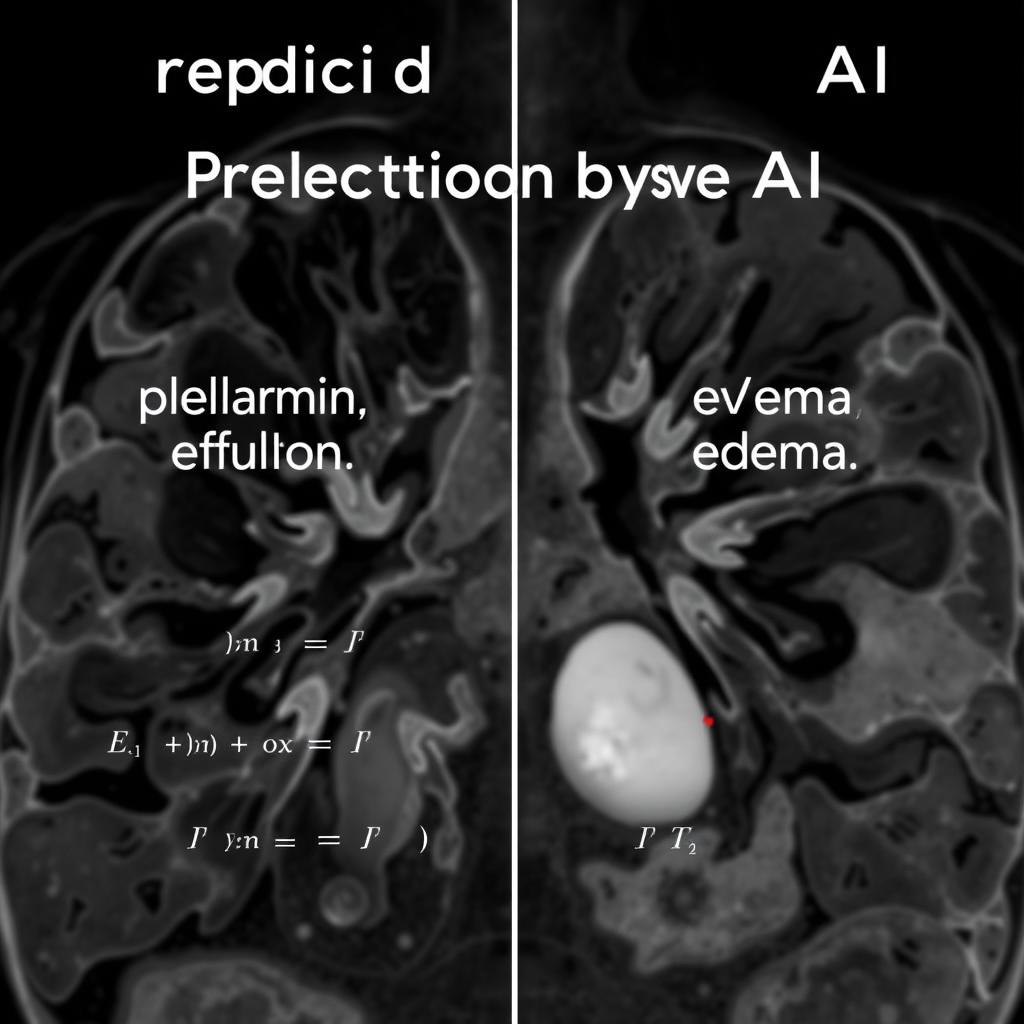

از اونجایی که مدلهای یادگیری ماشینی ممکنه پیشبینیهای اشتباهی داشته باشن، پژوهشگرها معمولاً این مدلها رو به یه قابلیت مهم، یعنی ارزیابی اعتماد به نفس توو تصمیمگیریهاشون مجهز میکنن. این موضوع مخصوصاً توو حوزههای حساس، مثل تشخیص بیماریها توو عکسهای پزشکی یا فیلتر کردن درخواستهای شغلی، خیلی اهمیت داره. اما تخمینهای عدم اطمینان یه مدل، فقط وقتی به درد میخورن که دقیق باشن. مثلاً، اگه یه مدل بگه که ۴۹٪ مطمئنه که یه عکس پزشکی افیوژن پلور رو نشون میده، باید توو ۴۹٪ از موارد این مدل درست از آب دربیاد.

یه سری محققای MIT یه روش جدید معرفی کردن که میتونه تخمینهای عدم اطمینان توو مدلهای یادگیری ماشین رو بهتر کنه. روششون نه تنها تخمینای عدم اطمینان دقیقتری نسبت به روشهای دیگه میده، بلکه این کار رو با راندمان بیشتری هم انجام میده. علاوه بر این، به خاطر مقیاسپذیری این روش، میشه اون رو رو مدلهای بزرگ و عمیق که دارن بیشتر توو مراقبتهای بهداشتی و جاهای حساس دیگه استفاده میشن، پیاده کرد. این تکنیک میتونه به کاربرای نهایی، که خیلیهاشون تخصص یادگیری ماشین ندارن، اطلاعاتی بده که بتونن تصمیم بگیرن که آیا به پیشبینیهای یه مدل اطمینان کنن یا نه، یا اینکه آیا اصلاً باید این مدل رو برای یه کار خاص استفاده کرد یا نه.

ناتان نگ، که دانشآموختهی دانشگاه تورنتو و یه دانشجوی مهمون توو MIT هست و نویسندهی اصلی این تحقیق، میگه: “آدم راحت میبینه که این مدلها توو جاهایی که خیلی خوب کار میکنن، عملکرد خوبی دارن و بعد فکر میکنه توو جاهای دیگه هم همینطورن. این موضوع اهمیت کارایی مثل این رو که دنبال بهتر کردن کالیبراسیون عدم اطمینان این مدلها هستن، بیشتر میکنه، تا مطمئن بشن که این عدم اطمینانها با درک انسانی از عدم اطمینان همخونی دارن.”

نگ این مقاله رو با راجر گروس، که استادیار علوم کامپیوتر دانشگاه تورنتو هست، و مژده قاسمی، استادیار دپارتمان مهندسی برق و علوم کامپیوتر و عضو مؤسسه علوم مهندسی پزشکی و آزمایشگاه سیستمهای اطلاعات و تصمیمگیری، نوشته. این تحقیق قراره توو کنفرانس بینالمللی یادگیری ماشین ارائه بشه.

تخمین عدم اطمینان

روشهای تخمین عدم اطمینان معمولاً به محاسبات آماری پیچیدهای نیاز دارن که برای مدلهای یادگیری ماشین با میلیونها پارامتر، خیلی هم مقیاسپذیر نیستن. این روشها همچنین از کاربرا میخوان که فرضیاتی در مورد مدل و دادههایی که برای آموزش اون استفاده شده، ارائه بدن. محققای MIT یه روش متفاوت رو انتخاب کردن. اونا از چیزی که به عنوان اصل حداقل طول توصیف (MDL) معروفه استفاده کردن، که نیازی به این فرضیات نداره و میتونه دقت روشهای دیگه رو تحت تأثیر قرار بده. MDL برای بهتر کردن تخمین و کالیبراسیون عدم اطمینان برای نقاط آزمایشی که از مدل خواسته شده تا اونها رو برچسبگذاری کنه، استفاده میشه.

تکنیکی که محققها توسعه دادن، اسمش IF-COMP هست، MDL رو اونقدر سریع میکنه که بشه ازش توو مدلهای عمیق و بزرگی که توو محیطای واقعی زیادی استفاده میشن، استفاده کرد. MDL شامل در نظر گرفتن تمام برچسبهای احتمالیه که یه مدل میتونه به یه نقطه آزمایشی اختصاص بده.

کاهش اعتماد مدلها با وجود برچسبهای جایگزین

اگه برای یه نقطهی دادهای برچسبهای جایگزین زیادی وجود داشته باشه که باهاش خوب جور دربیان، اعتماد مدل به برچسبی که انتخاب کرده، باید کم بشه. نگ میگه: “یه راه واسه فهمیدن میزان اعتماد یه مدل اینه که اطلاعات ضد و نقیض بهش بدی و ببینی چهقدر احتمال داره که حرفتو باور کنه.” مثلاً، فرض کن یه مدل میگه که یه عکس پزشکی افیوژن پلور رو نشون میده. اگه محققا به مدل بگن که این عکس داره ادم رو نشون میده و مدل حاضر باشه نظرشو عوض کنه، در این صورت باید به تصمیم اولیهاش کمتر اعتماد کنه.

پیچیدگی دادههای تصادفی و کدگذاری

با استفاده از MDL، اگه یه مدل توو برچسبگذاری یه نقطهی داده مطمئن باشه، باید یه کد خیلی کوتاه برای توصیف اون نقطه استفاده کنه. اگه در مورد تصمیمش مطمئن نباشه، چون اون نقطه میتونه برچسبای دیگهای هم داشته باشه، باید از یه کد بلندتر برای پوشش دادن این احتمالات استفاده کنه. مقدار کدی که برای برچسبگذاری یه نقطهی داده بهکار میره، به عنوان پیچیدگی دادههای تصادفی شناخته میشه. اگه محققا از مدل بپرسن که چهقدر حاضره نظرشو در مورد یه نقطه داده با توجه به شواهد متناقض عوض کنه، پیچیدگی دادههای تصادفی باید کم بشه، اگه مدل مطمئن باشه. اما آزمایش هر نقطهی دادهای با استفاده از MDL، به محاسبات خیلی زیادی نیاز داره.

سریعتر کردن فرآیند با IF-COMP

با IF-COMP، محققا یه تکنیک تقریبی توسعه دادن که میتونه پیچیدگی دادههای تصادفی رو با استفاده از یه تابع خاص به نام تابع تأثیر، با دقت تخمین بزنه. اونا همچنین از یه تکنیک آماری به اسم مقیاسگذاری دما استفاده کردن که کالیبراسیون خروجیهای مدل رو بهتر میکنه. این ترکیب تابع تأثیر و مقیاسگذاری دما، امکان تخمینای باکیفیت از پیچیدگی دادههای تصادفی رو فراهم میکنه. در نهایت، IF-COMP میتونه به طور کارآمد مقادیر عدم اطمینان رو تولید کنه که خوب کالیبره شدهان و اعتماد واقعی مدل رو نشون میدن.

شناسایی نقاط دادهی اشتباه برچسبگذاری شده

این تکنیک همچنین میتونه تعیین کنه که آیا مدل بعضی از نقاط داده رو اشتباه برچسبگذاری کرده یا نقاط دادهای که از محدوده خارج هستن رو شناسایی کنه. محققان سیستمشون رو رو این سه تا کار آزمایش کردن و دیدن که این سیستم از روشهای دیگه سریعتر و دقیقتر عمل میکنه. غاسمی میگه: “واقعاً مهمه که مطمئن باشیم یه مدل خوب کالیبره شده و یه نیاز رو به افزایشه که بفهمیم کی یه پیشبینی خاص درست به نظر نمیرسه. ابزارهای حسابرسی توو مسائل یادگیری ماشین، به خاطر استفاده از حجم زیادی از دادههای بررسی نشده برای ساختن مدلهایی که به مشکلات انسانی اعمال میشن، دارن ضروریتر میشن.”

کاربردهای گستردهی IF-COMP

IF-COMP به مدل خاصی وابسته نیست، برای همین میتونه مقادیر عدم اطمینان دقیقی رو برای انواع مختلف مدلهای یادگیری ماشین ارائه بده. این میتونه بهش کمک کنه که توو یه دامنهی وسیعتری از محیطای واقعی به کار گرفته بشه و در نهایت به بیشترین تعداد از متخصصا کمک کنه تا تصمیمهای بهتری بگیرن. نگ میگه: “مردم باید درک کنن که این سیستمها خیلی هم بیخطا نیستن و ممکنه توو حین کار چیزایی رو تشخیص بدن. یه مدل ممکنه اینطور به نظر برسه که خیلی مطمئنه، اما در واقع ممکنه چیزای زیادی وجود داشته باشه که با توجه به شواهد متناقض، حاضره اونا رو باور کنه.”

آیندهی پژوهشا

توو آینده، محققان میخوان که روششون رو توو مدلهای زبانی بزرگ بهکار بگیرن و موارد استفادهی احتمالی دیگه رو برای اصل حداقل طول توصیف بررسی کنن.

بیشتر بخوانید

مدیتیشن یک روز پربرکت برای جذب عشق وامنیت و سلامتی

خود هیپنوتیزم درمان زود انزالی در مردان توسط هیپنوتراپیست رضا خدامهری

تقویت سیستم ایمنی بدن با خود هیپنوتیزم

شمس و طغری

خود هیپنوتیزم ماندن در رژیم لاغری و درمان قطعی چاقی کاملا علمی و ایمن

خود هیپنوتیزم تقویت اعتماد به نفس و عزت نفس