کاوش در توضیحات مدلهای یادگیری ماشینی

مدلهای یادگیری ماشین بالاخره یه جاهایی ممکنه گند بزنن و فهمیدنشون هم سخت باشه. واسه همین، دانشمندا روشهای توضیحی رو آوردن که به آدما کمک کنه بفهمن کی و چجوری باید به پیشبینیهای یه مدل اعتماد کنن. البته این توضیحات بعضی وقتا پیچیده میشن و ممکنه شامل اطلاعاتی در مورد صدها تا ویژگی مدل باشن. بعضی موقعا هم این توضیحات رو به شکل نمودارهای چندبعدی نشون میدن که واسه کسایی که سررشتهای از یادگیری ماشین ندارن، درکشون سخت میشه.

خلاصه کردن توضیحات به زبون ساده

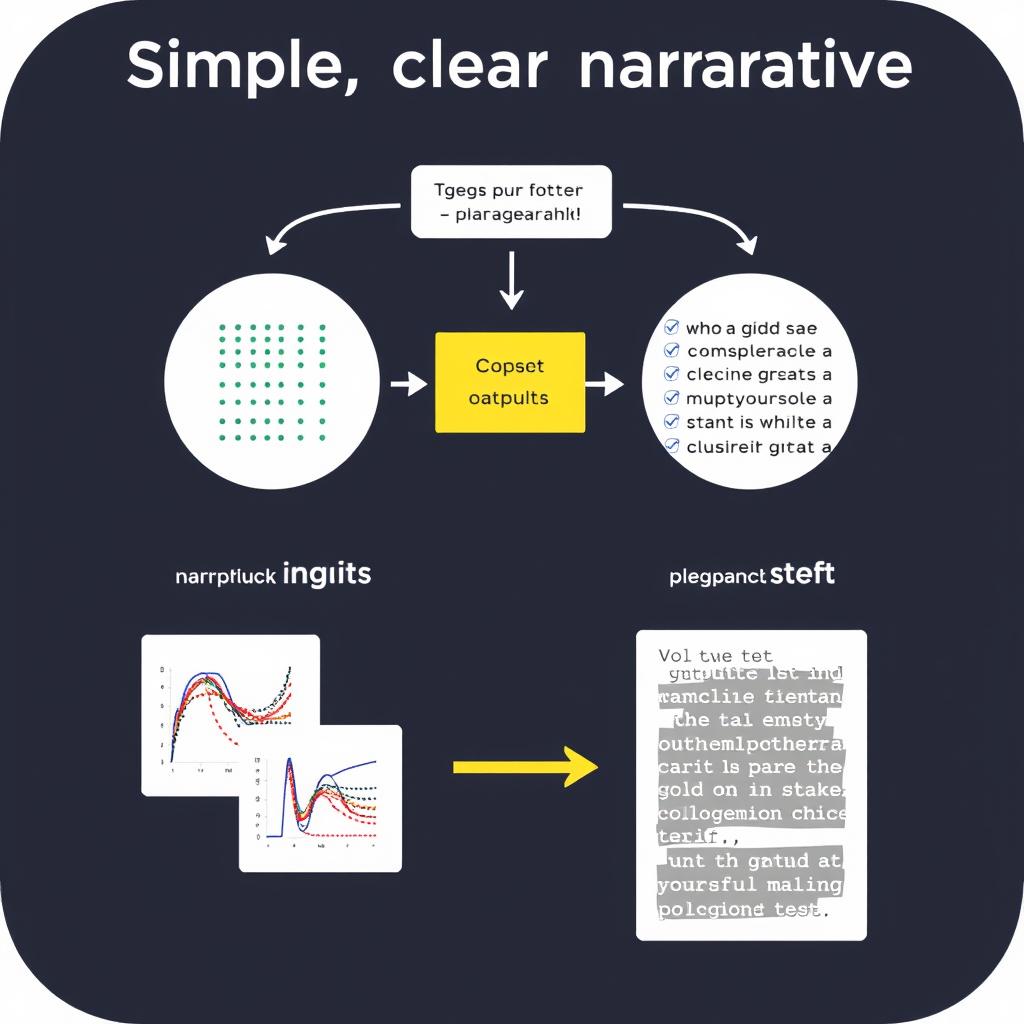

محققای MIT واسه اینکه ملت بتونن توضیحات هوش مصنوعی رو بفهمن، از مدلهای زبانی بزرگ (LLMs) استفاده کردن تا توضیحات مبتنی بر نمودار رو به زبان ساده تبدیل کنن. اونا یه سیستم دو قسمتی ساختن که توضیحات یادگیری ماشین رو به یه پاراگراف متنی تبدیل میکنه که آدما بتونن بخونن و بعدش هم بهطور خودکار کیفیت این توضیح رو بررسی میکنه تا کاربر نهایی بفهمه باید بهش اعتماد کنه یا نه. محققا با دادن چند نمونه توضیح به سیستم، میتونن توضیحات رو متناسب با سلیقه کاربر یا نیازهای برنامههای خاص تنظیم کنن.

در آینده، محققا امیدوارن که با استفاده از این روش، به کاربرها اجازه بدن که از مدلها سوالای بیشتری بپرسن تا بفهمن پیشبینیها توی شرایط واقعی چجوری بهدست اومدن. الکساندرا زایتک، دانشجوی دکتری رشته مهندسی برق و علوم کامپیوتر و نویسنده اصلی یه مقاله در این مورد، میگه: «هدف ما اینه که یه قدم اول برداریم تا کاربرها بتونن با مدلهای یادگیری ماشین در مورد دلیل پیشبینیهای خاص گپ بزنن و در نهایت بتونن تصمیم بگیرن که به حرف مدل گوش بدن یا نه». زایتک توی این مقاله با سارا پیدو، که محقق پسادکترا توی MIT هست؛ سارا الناقیمیش، دانشجوی دکتری EECS؛ لور برتی-اکویل، مدیر پژوهش در مؤسسه ملی تحقیقات فرانسه و کالیان ویرامچاننی، دانشمند ارشد پژوهش در آزمایشگاه سیستمهای اطلاعات و تصمیمگیری همکاری کرده. این تحقیق قراره توی کنفرانس IEEE Big Data ارائه بشه.

توضیحات SHAP

محققین روی یه نوع خیلی معروف از توضیحات یادگیری ماشین به اسم SHAP تمرکز کردن. توی یه توضیح SHAP، به هر ویژگی که مدل برای پیشبینی استفاده میکنه، یه مقدار اختصاص داده میشه. مثلاً اگه یه مدلی قیمت خونهها رو پیشبینی کنه، یکی از این ویژگیها میتونه موقعیت خونه باشه. به موقعیت یه مقدار مثبت یا منفی میدن که نشون میده این ویژگی چقدر روی پیشبینی کلی مدل تأثیر داره. معمولا، توضیحات SHAP رو به شکل نمودارهای میلهای نشون میدن که مشخص میکنه کدوم ویژگیها مهمتر یا کماهمیتتر هستن. اما واسه یه مدل با بیشتر از 100 تا ویژگی، اون نمودار میلهای خیلی زود میشه یه چیزی که نمیشه مدیریتش کرد.

ویرامچاننی میگه: «ما محققا، باید کلی انتخاب کنیم که چی رو میخوایم بهصورت بصری نشون بدیم. اگه تصمیم بگیریم فقط 10 تا از مهمترین ویژگیها رو نشون بدیم، ممکنه ملت بپرسن بقیه ویژگیها چی شدن. استفاده از زبان طبیعی این آزادی عمل رو به ما میده که دیگه این انتخابا رو نکنیم». ولی محققا بهجای اینکه یه مدل زبانی بزرگ رو بذارن توضیحات رو به زبان طبیعی بسازه، از LLM استفاده کردن تا یه توضیح SHAP موجود رو تبدیل به یه داستان کنن که بشه خوندش.

معرفی سیستم EXPLINGO

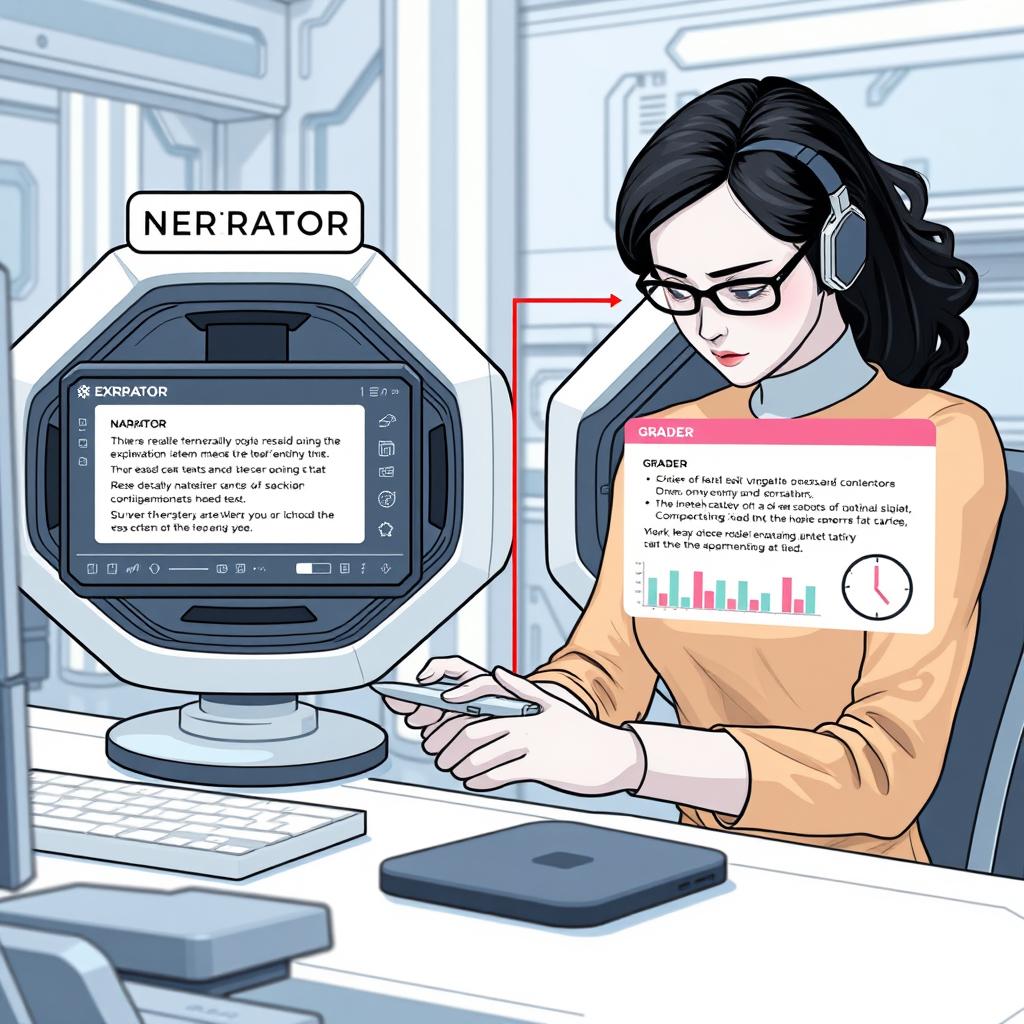

زیتک توضیح میده که با سپردن فقط بخش زبانی به LLM، احتمال اشتباه توی توضیحات کم میشه. سیستم اونا، که اسمش EXPLINGO هست، به دو قسمت تقسیم میشه که با هماهنگی کار میکنن. قسمت اول، که اسمش NARRATOR هست، از LLM استفاده میکنه تا توضیحات داستانی بسازه از توضیحات SHAP که با سلیقه کاربر همخونی داشته باشه. با ارائه 3 تا 5 تا نمونه نوشته شده از توضیحات داستانی به NARRATOR، LLM سبکش رو موقع تولید متن تقلید میکنه.

سفارشیسازی آسون NARRATOR

زیتک میگه: «بهجای اینکه کاربر بخواد توضیح بده که چه جور توضیحیو میخواد، بهتره فقط بنویسه که چی میخواد ببینه.» این کار باعث میشه که NARRATOR خیلی راحت، با نشون دادن یه سری مثال دستنویس، واسه موارد جدید سفارشی بشه. بعد از اینکه NARRATOR یه توضیح سادهدرست کرد، قسمت دوم، که اسمش GRADER هست، از LLM استفاده میکنه تا توضیح رو بر اساس چهار تا معیار بررسی کنه: خلاصه بودن، دقیق بودن، کامل بودن و روان بودن. GRADER بهطور خودکار LLM رو با متن NARRATOR و توضیح SHAP که داره توضیح میده، راهنمایی میکنه.

دقت توی ارزیابی

زیتک میگه: «ما فهمیدیم که حتی وقتی یه LLM یه کاری رو اشتباه انجام میده، معمولا توی بازبینی یا تایید اون کار اشتباه نمیکنه». کاربرها هم میتونن GRADER رو جوری تنظیم کنن که به هر معیار وزن متفاوتی بده. اون اضافه میکنه: «شما میتونید تصور کنید که توی یه مورد حساس، وزن دقت و کامل بودن خیلی بیشتر از روان بودن باشه».

تحلیل داستانها

واسه زیتک و همکاراش، یکی از بزرگترین چالشها این بود که LLM رو طوری تنظیم کنن که داستانهای طبیعی تولید کنه. هرچی دستورالعملهای بیشتری برای کنترل سبک اضافه میکردن، احتمال اینکه LLM توی توضیحاتش اشتباه کنه، بیشتر میشد. اون میگه: «کلی تنظیمات دستورالعملها رو انجام دادیم تا بتونیم هر اشتباهو دونه دونه پیدا کنیم و درستش کنیم.» محققا واسه تست سیستمشون، 9 تا مجموعه داده یادگیری ماشین با توضیحات رو انتخاب کردن و از کاربرای مختلف خواستن که برای هر مجموعه داده یه داستان بنویسن. این کار بهشون این امکانو داد که توانایی NARRATOR رو توی تقلید از سبکهای منحصر به فرد بسنجن. اونا از GRADER استفاده کردن تا به هر توضیح داستانی بر اساس اون چهارتا معیار نمره بدن.

نتایج و پیشرفتها

در نهایت، محققا دیدن که سیستمشون میتونه توضیحات داستانی با کیفیت بالا تولید کنه و بهطور موثری از سبکهای نوشتاری مختلف تقلید کنه. نتایجشون نشون میده که ارائه چند مثال دستی، سبکه داستاننویسی رو خیلی بهتر میکنه. اما این مثالا باید با دقت نوشته بشن؛ چون استفاده از کلمات مقایسهای مثل «بزرگتر» ممکنه باعث بشه که GRADER توضیحات دقیقو اشتباه علامت بزنه.

آینده EXPLINGO

بر اساس این نتایج، محققا میخوان تکنیکایی رو بررسی کنن که میتونه به سیستمشون کمک کنه تا بهتر با کلمات مقایسهای کنار بیاد. اونا همچنین میخوان EXPLINGO رو با اضافه کردن توجیه به توضیحات گسترش بدن. در درازمدت، اونا امیدوارن که از این کار بهعنوان یه پایه محکم واسه ساختن یه سیستم تعاملی استفاده کنن که توی اون کاربر بتونه از مدل سوالای بیشتری درمورد یه توضیح بپرسه. زیتک میگه: «این میتونه توی تصمیمگیری به روشهای مختلف کمک کنه. اگه آدما با پیشبینی یه مدل اختلاف نظر داشته باشن، ما میخوایم که بتونن سریع بفهمن که آیا حسشون درسته یا حس مدل و اینکه این تفاوت از کجا ناشی میشه.»

“`

بیشتر بخوانید

مدیتیشن یک روز پربرکت برای جذب عشق وامنیت و سلامتی

خود هیپنوتیزم درمان زود انزالی در مردان توسط هیپنوتراپیست رضا خدامهری

تقویت سیستم ایمنی بدن با خود هیپنوتیزم

شمس و طغری

خود هیپنوتیزم ماندن در رژیم لاغری و درمان قطعی چاقی کاملا علمی و ایمن

خود هیپنوتیزم تقویت اعتماد به نفس و عزت نفس