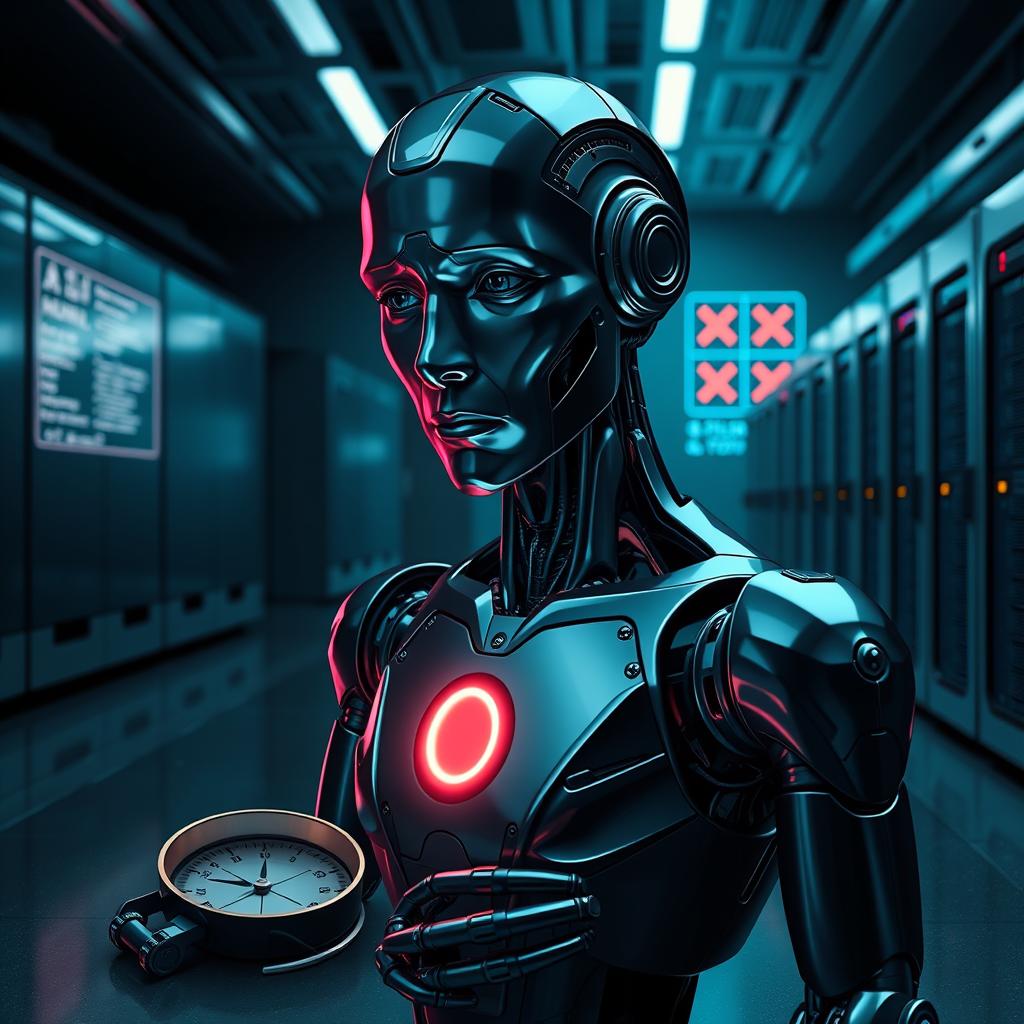

یه پژوهش تازه نفس: انتقاد بیشتر به هوش مصنوعیها وقتی مثل آدما فکر میکنن

تو یه تحقیق جدید، معلوم شده شرکتکنندهها دوست داشتن بیشتر به هوش مصنوعی (AI) که تو کارهای خلاف اخلاق واقعی دست داشتن، گیر بدن؛ اونم وقتی که حس میکردن مغزی شبیه آدم دارن. مینجو جو از دانشگاه زنان سوکمیونگ تو سئول، کره، این کشفها رو تو مجلهی PLOS ONE که دسترسی بهش آزاده، 18 دسامبر 2024 منتشر کرد.

تحقیقات قبلی نشون داده بود مردم معمولا هوش مصنوعی رو مقصر کارای غیراخلاقی مختلف میدونن؛ مثل وقتی یه ماشین خودران به یه عابر پیاده میزنه یا تصمیمهایی که باعث آسیبهای پزشکی یا نظامی میشن. مطالعات بیشتر هم اینو ثابت کرده که آدمها بیشتر به هوش مصنوعیهایی گیر میدن که توانایی آگاهی، فکر کردن و برنامهریزی دارن. انگار مردم این قابلیتها رو بیشتر به هوش مصنوعیهایی نسبت میدن که حس میکنن مغز آدمیزادی دارن و میتونن احساسات آگاهانه رو تجربه کنن.

جو با توجه به این تحقیقات قبلی، حدس زد هوش مصنوعیهایی که مغز آدمیزادی دارن، ممکنه سهم بیشتری از انتقادها رو برای یه کار خلاف اخلاقی خاص بگیرن.

تحقیق دربارهی اینکه هوش مصنوعی چقدر مسئولیت داره

جو برای اینکه این ایده رو امتحان کنه، چند تا آزمایش انجام داد که توش شرکتکنندهها با نمونههای واقعی از کارهای غیراخلاقی هوش مصنوعی روبهرو شدن. مثلا، یکی از اینا برچسبگذاری نژادپرستانه رو عکسها بود. تو این آزمایشا، از شرکتکنندهها سوالایی پرسیده میشد تا بفهمن چطوری به هوش مصنوعیها فکر میکنن و همینطور میزان مسئولیتی که برای هوش مصنوعی، برنامهنویس، شرکت سازنده یا دولت قائل هستن چیجوریه.

تو بعضی موارد، نظر شرکتکنندهها دربارهی هوش مصنوعی با دادن اسم، سن، قد و سرگرمی بهش عوض میشد. تو این آزمایشا، شرکتکنندهها وقتی هوش مصنوعی رو یه موجود شبیه آدم میدیدن، بیشتر مسئول میدونستنش. تو این شرایط، وقتی از شرکتکنندهها خواسته میشد مسئولیت رو تقسیم کنن، کمتر به شرکت مربوطه مسئولیت میدادن. اما وقتی خواسته میشد سطح مسئولیت رو برای هر کدوم از عوامل جداگانه بسنجن، تغییری تو میزان مسئولیت شرکت دیده نمیشد.

این نتایج نشون میده که اینکه چطور به هوش مصنوعی نگاه میکنیم، یه عامل خیلی مهم تو اینکه کی رو مسئول کارهای خلاف اخلاق میدونیم. علاوه بر این، جو دربارهی خطرهای احتمالی سوءاستفاده از هوش مصنوعی به عنوان قربانی اخلاقی هشدار میده و میگه باید بیشتر تو این زمینه تحقیق بشه. نویسنده اضافه میکنه: «آیا میشه هوش مصنوعی رو بابت کارهای غیراخلاقی مقصر دونست؟ این تحقیق نشون میده که اگه هوش مصنوعی رو موجودی مثل آدم بدونیم، مسئولیت نسبت به اون بیشتر میشه و در عین حال مسئولیت نسبت به آدمایی که درگیر هستن، کم میشه. همین باعث میشه نگران استفاده از هوش مصنوعی به عنوان قربانی اخلاقی بشیم.»

بیشتر بخوانید

مدیتیشن یک روز پربرکت برای جذب عشق وامنیت و سلامتی

خود هیپنوتیزم درمان زود انزالی در مردان توسط هیپنوتراپیست رضا خدامهری

تقویت سیستم ایمنی بدن با خود هیپنوتیزم

شمس و طغری

خود هیپنوتیزم ماندن در رژیم لاغری و درمان قطعی چاقی کاملا علمی و ایمن

خود هیپنوتیزم تقویت اعتماد به نفس و عزت نفس